Comprendiendo la métrica AUC-ROC en modelos de Deep Learning

Una guía sobre el Área Bajo la Curva de Características Operativas del Receptor

Cuando se trata de evaluar modelos de deep learning, una métrica crítica que se utiliza comúnmente es el Área Bajo la Curva de Características Operativas del Receptor (AUC-ROC, por sus siglas en inglés). Esta métrica proporciona una medida cuantitativa de la capacidad de discriminación de un modelo y su capacidad para clasificar correctamente ejemplos positivos y negativos. En este artículo, exploraremos qué es el AUC-ROC, cómo interpretarlo y su relevancia en el contexto de la evaluación de modelos de machine learning.

¿Qué es AUC-ROC?

El AUC-ROC es una métrica que se utiliza para evaluar modelos de clasificación binaria. La sigla AUC significa "Área Bajo la Curva", y ROC se refiere a "Características Operativas del Receptor". La curva ROC es una representación gráfica de cómo un modelo discrimina entre ejemplos positivos y negativos en función de diferentes umbrales de decisión. Cuanto mayor sea el área bajo la curva ROC, mejor será el rendimiento del modelo. En otras palabras, mide qué tan bien puede distinguir el modelo entre dos clases diferentes, generalmente etiquetadas como positiva (1) y negativa (0).

La curva ROC muestra dos métricas clave:

Tasa de Verdaderos Positivos (True Positive Rate o TPR): Esto mide la capacidad del modelo para identificar correctamente los ejemplos positivos. Cuanto mayor sea el TPR, mejor será el modelo en la detección de casos positivos.

Tasa de Falsos Positivos (False Positive Rate o FPR): Esto mide la capacidad del modelo para generar falsas alarmas al clasificar incorrectamente ejemplos negativos como positivos. Cuanto menor sea el FPR, mejor será el modelo en evitar falsos positivos.

Interpretando AUC-ROC

La interpretación del AUC-ROC se puede dividir en cuatro categorías principales:

AUC-ROC de 0.5: Un AUC-ROC de 0.5 indica que el modelo no tiene capacidad de discriminación y sus predicciones son tan buenas como el azar. Esto se considera un rendimiento deficiente.

AUC-ROC entre 0.7 y 0.8: Un AUC-ROC en este rango se considera aceptable. Indica que el modelo tiene cierta capacidad de discriminación, pero aún hay margen para mejorar.

AUC-ROC entre 0.8 y 0.9: Este rango se considera bueno. Un modelo con un AUC-ROC en este intervalo tiene una capacidad sólida para distinguir entre clases positivas y negativas.

AUC-ROC de 0.9 o superior: Un AUC-ROC superior a 0.9 se considera excelente. Indica que el modelo tiene una alta capacidad de discriminación y es eficaz en la clasificación.

Un AUC-ROC debajo de 0.5 generalmente indica que el modelo de clasificación está funcionando peor que una clasificación aleatoria.

Contexto importa

Es importante recordar que la interpretación del AUC-ROC debe considerar el contexto del problema. En algunas aplicaciones, como la detección de fraudes o problemas médicos críticos, se puede requerir un AUC-ROC cercano a 1.0 para ser efectivo. En otros casos, un rendimiento ligeramente inferior podría ser relevante.

Equilibrio entre métricas

Además del AUC-ROC, es fundamental considerar otras métricas de evaluación, como precisión, recall y especificidad, según los requisitos específicos del problema. A menudo, existe un equilibrio entre estas métricas, y la elección de un umbral de decisión adecuado puede influir en el rendimiento general del modelo.

Para una comprensión más clara, echemos un vistazo a algunos ejemplos:

Ejemplos:

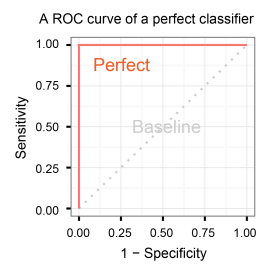

Modelo perfecto (AUC = 1)

Supongamos que tienes un modelo que puede distinguir perfectamente entre correos electrónicos legítimos (clase 0) y correos no deseados (clase 1). Cada punto de datos representa un correo electrónico, y la curva ROC se ve como esta:

En este caso, el AUC es igual a 1. El modelo nunca comete errores y siempre coloca los correos electrónicos en la clase correcta.

Modelo aleatorio (AUC = 0.5)

Ahora imagina que tienes un modelo que simplemente adivina al azar si un correo electrónico es legítimo o no. La curva ROC podría verse así:

El AUC en este caso es 0.5, lo que significa que el modelo no es mejor que una elección al azar.

Modelo con capacidad de discriminación (0.5 < AUC < 1)

La mayoría de los modelos reales caen en esta categoría. Supongamos que tienes un modelo de filtro de spam que es bueno, pero no perfecto. La curva ROC podría verse así:

Aquí, el AUC está entre 0.5 y 1 en modelos de clasificación, modelo A y modelo B, lo que indica que ambos modelos son capaces de distinguir entre correos legítimos y spam, pero cometen algunos errores.

Conclusión

En resumen, el AUC-ROC es una métrica esencial para evaluar modelos de deep learning en problemas de clasificación binaria. Interpretarlo adecuadamente y considerarlo en el contexto del problema puede ayudar a maximizar el rendimiento del modelo y tomar decisiones informadas en la implementación de soluciones basadas en inteligencia artificial. Es una herramienta valiosa para medir la capacidad de discriminación y la eficacia general de los modelos, lo que lo convierte en un componente crucial en el desarrollo y la evaluación de algoritmos de machine learning.

En este video puedes encontrar información mas detallada